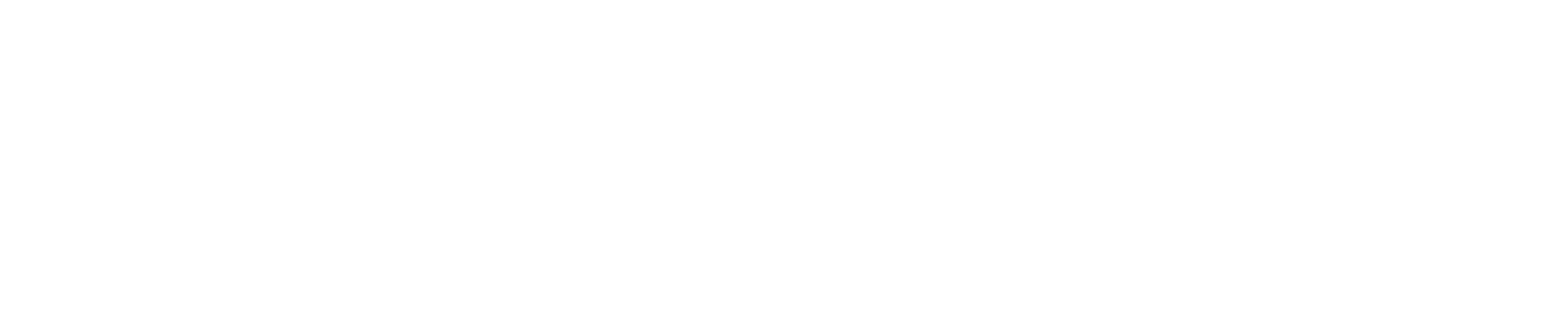

Para atender estas premissas, é importante que passemos por alguns tópicos e o encadeamento e dependência entre eles. No esquema abaixo, o ciclo de retroalimentação de uma estratégia que atuará sobre um determinado processo e fundamentada em análises dos resultados obtidos e todo este ciclo só é possível se fundados em dados corretos. Entenda como estratégia o conjunto de decisões tomadas, implementadas e executadas em sua plenitude.

Sem os dados nada é possível em analytics, portanto vamos começar pelo começo.

Para ter boa capacidade de análise sobre cada processo na gestão de risco, é estabelecer desde o começo uma estrutura de dados que possibilite desenvolver análises para responder todas as perguntas que você pretende fazer e, obtendo as respostas, tenhamos capacidade de fazer mudanças no processo para corrigir rumos, acelerar bons resultados ou melhorar a relação custo-benefício de determinada ação ou estratégia implementada.

Uma boa estrutura de dados deve ser capaz de coletar os dados que serão organizados e armazenados para que possam ser facilmente acessados, gerenciados, atualizados e recuperados para geração das informações desejadas.

Uma forma de organizar os dados é criar um banco de dados relacional que nada mais é do que desenvolver banco de dados sob a metodologia de modelo de entidade de relacionamento que permitirá de forma técnica o mapeamento das fonted de dados, identificar e classificar as diferentes entidades e seus relacionamentos. Isto o ajudará saber claramente a fonte dos dados, os conceitos definidos, a posição deles no tempo, sua precisão, definição de chaves de relacionamentos evitando assim duplicidades, inconsistências de relacionamentos entre elas e principalmente evitar conceitos distintos para a mesma informação. Situação muito comum no mercado, inclusive em grandes organizações.

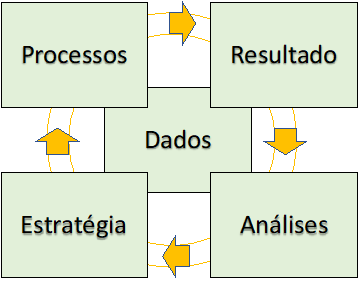

Como exemplo, poderíamos listar algumas entidades possíveis: Cliente, Cadastral, empréstimo e Pagamentos dentre outras possibilidades e para cada entidade atributos, relacionamentos e cardinalidade.

Neste exemplo temos duas entidades, cliente e cadastro, com seus domínios específicos que estão relacionados com chave única Id Cliente, presentes nas duas entidades e na relação cliente-> cadastro mostra, através do símbolo específico para esta situação (*1), que um cliente pode ter um ou vários cadastros e na relação cadastro->cliente, a relação é sempre de no mínimo um cliente por cadastro e somente um.

*(1) Os símbolos são convenção do modelo e existem outras possibilidades.

Aqui, meu objetivo não é discorrer sobre técnicas de construção de banco de dados e devem existir inúmeras formas diferentes da apresentada, mas sim chamar a atenção sobre a importância da qualidade dos dados, do histórico que pretende manter e tempestividade que são condições fundamentais e subsidiarão o sistema de informações gerenciais, bases para suas análises e desenvolvimento de modelos estatísticos que, uma vez estando corretos o levarão às decisões corretas e no caso oposto à caminhos tortuosos e onerosos.

Em pesquisa recente elaborada pela Unioneblue com executivos da área de risco de crédito, identificamos que cerca de 50% demonstraram preocupação com a confiança nos dados de seus bancos de dados, seja pela quantidade de bancos de dados utilizados e necessários para compor uma informação ou para estabelecer uma base para estudos analíticos mais profundos. Outra descoberta foi que estas bases têm diversas linguagens ou tipos de bancos de dados o que complica o ambiente como um todo. Redundâncias de fontes de mesma informação que produzem resultados diferentes por terem conceitos distintos também é recorrente nas organizações.

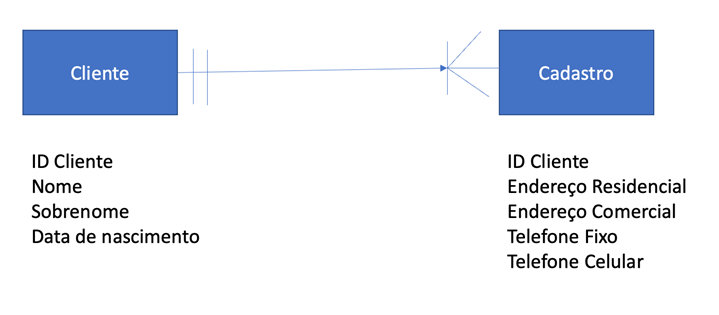

No gráfico abaixo temos o resultado obtido pela colaboração dos 62 respondentes em classificar o grau de impacto negativo da qualidade e confiabilidade dos dados disponibilizados pela empresa no trabalho específico de analytics. Somente 11,3% dizem não sofrer nenhum impacto por este fator e na outra ponta, 56,5% dizem-se impactados negativamente de forma relevante ou extrema.

Fonte Unioneblue – Pesquisa sobre desafios nas áreas de analytics Jul/21

Em um ambiente novo, como em uma startup ou em uma empresa recentemente fundada é muito mais fácil estabelecer um bom fluxo de dados e de geração de informações para tomada de decisão. Em organizações mais longevas e, independente do tamanho, é sempre uma tarefa sempre muito mais difícil e aqui vale aquela máxima “ter que trocar a turbina do avião em pleno voo”.

Independente do nível de evolução de seus bancos de dados, não escapará da árdua missão de fazer a validação dos dados, das origens/fontes, do processo de manutenção delas, do histórico e principalmente da manutenção constante pela perecibilidade de algumas delas. Não obstante, alguns trabalhos são baseados em fontes de dados que deixam de existir ou por legislação proibidos, o que fará você certamente perder muito tempo em achar substitutos ou rever os indicadores, modelos e o book de indicadores baseados nestes dados.

Objetivo

“Quando se navega sem destino, nenhum vento é favorável” e com base na frase do filósofo romano Sêneca, devemos ser muito cuidadosos na definição dos nossos objetivos e de toda a cadeia de metas e submetas que se fazem necessárias para atingir o que se pretende.

São várias as técnicas disponíveis, mas independente de qual seja sua escolha, necessita-se saber claramente a que se refere aquele objetivo principal e a que se propõe, seja mensurável, tangível, relevante e temporal.

* Sigla em inglês SMART (Specific, Measurable, Attainable, Relevant and Time Based).

Identificar o(s) objetivo(s) do seu trabalho é o primeiro passo, e irá variar caso a caso. Para o desenvolvimento de uma árvore de decisão, que tenha como objetivo identificar o perfil de um cliente devedor de maior probabilidade de pagar a dívida, por exemplo, exigirá um exercício exploratório para estruturar suas hipóteses e quais perguntas você precisa fazer para validá-las ou não. Uma vez identificado o objetivo é definir o caminho será necessário detalhar os dados que serão necessários para desenvolver a análise e responder as perguntas iniciais.

O mesmo exercício servirá para avaliação de outros objetivos e quanto melhor estiver estruturada as suas perguntas, melhor será a escolha dos dados e consequentemente os resultados.

Sempre bom ter em perspectiva a relação de causa e efeito mapeadas, isto facilitará a construção das hipóteses e consequente qualidade das perguntas. Se você não conhece o processo profundamente seja ele qual for, aconselho a conhecê-lo antes de formular situações que não existam e que lhe subtrairão tempo de análise das situações reais e importantes.

Defina o nível de granularidade que deseja mergulhar antes de especificar sua base de trabalho, voltar à prancheta depois das bases prontas exigirá tempo, recurso caro na área de analytics.

Definindo as medidas e dimensões de análise

Com esta etapa anterior completa, o próximo passo é a definição de medidas e as dimensões. Supondo que você queira saber quantos clientes atrasados por região, faixa de atraso, saldos, se possuem telefones e a média de telefones de contato por cliente. Sem as dimensões Faixas de atraso, Estado/Cidade, Ter Telefone ou não e as medidas de Saldo em Atraso, Quantidade de telefones e # clientes, você não terá o que deseja de informação.

Softwares utilizados

Ferramenta adequada para cada situação é muito importante. Vocês já ouviram a frase “estamos matando uma formiga com uma arma de matar elefante”, na verdade, aqui temos um problema recorrente de uso de ferramentas não adequadas ao tamanho ou o tipo do problema e é comum o sub-dimensionamento na escolha delas, seja pelo custo ou desconhecimento.

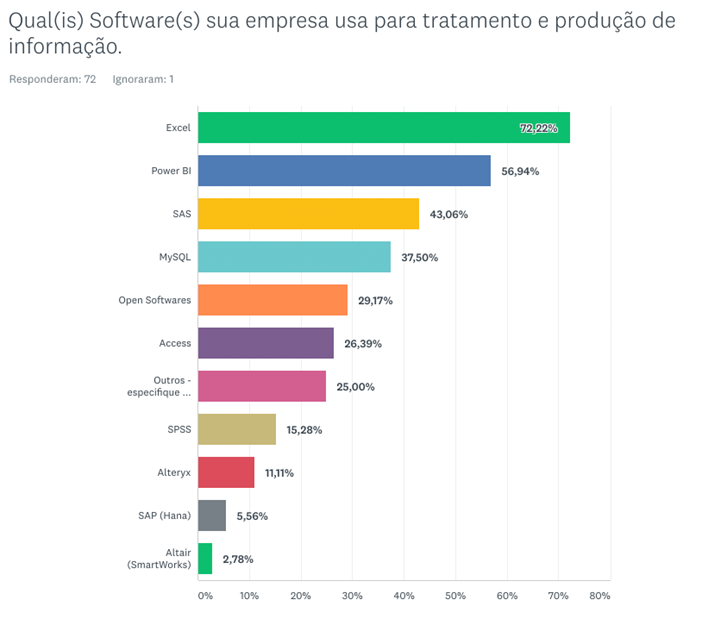

Na mesma pesquisa desenvolvida pela Unioneblue mencionada, tivemos os seguintes resultados. Dos 72 respondentes que poderiam utilizar mais de uma escolha, resultou um total de 234 marcações, uma média de 3,25 marcações (softwares) por respondente, que nos leva a concluir que não há uma solução que contemple todas as necessidades no ciclo de desenvolvimento de um trabalho analítico. Em outras palavras, para desenvolvermos um trabalho desde a preparação e verificação dos dados, trabalho analítico desejado, documentação e apresentação usa-se mais de uma solução.

Fonte Unioneblue – Pesquisa sobre desafios nas áreas de analytics Jul/21

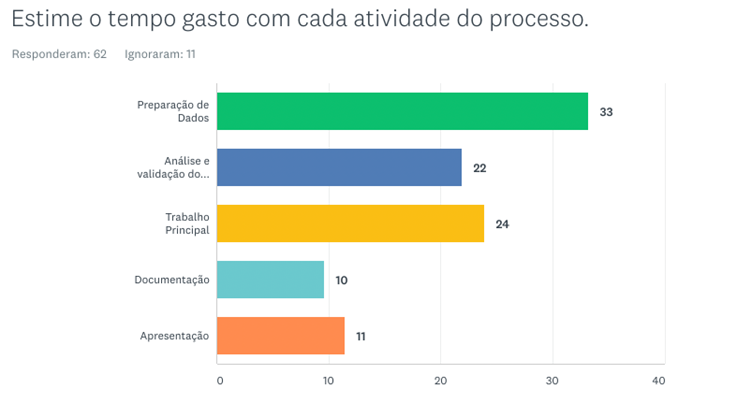

Não sabemos ao certo a razão específica e talvez seja um combinado de vários fatores, mas a etapa de preparação e validação de dados é responsável por 55% do tempo gasto no processo de um projeto de estudo analítico. O trabalho específico de análise em si fica reduzido a 24% do tempo total do ciclo de um estudo.

As razões conhecidas são, dependência de outra área para conseguir os dados, diversidade de tipos de banco de dados, múltiplas fontes, dificuldade em acesso a dados externos e por último a utilização de diversas plataformas tecnológicas para concluir um trabalho de preparação e validação de dados.

Fonte Unioneblue – Pesquisa sobre desafios nas áreas de analytics Jul/21

O problema do muito, do pouco e quando devemos parar de prospectar.

Invariavelmente quando temos pouca informação, temos que tomar uma decisão e na impossibilidade de angariarmos mais dados decidimos há grande chance de decidir mal e o mesmo risco corremos quando temos muita informação. A insegurança é praticamente a mesma nos dois casos explico: Se temos uma informação básica e temos que decidir com ela, temos ciência de que não é o suficiente e temos que decidir, decidimos cientes do risco intrínseco à situação. Quando temos muitas informações, acabamos dominados pelas análises infindáveis, de teorias que se desmentem entre si e que ao final, decidimos igualmente inseguros e no limite do tempo. É claro que na segunda hipótese é muito mais confortável que a primeira.

Na segunda situação a preocupação está na capacidade de identificar quando o investimento em tempo e recursos está ultrapassando o benefício que sua pesquisa trará. Existe sempre a preocupação com o trade-off e precisamos acompanha-lo em todas as fases e decisões de prolongamento ou não dos estudos.

Capacidade Analítica

Sem um bom recurso em analise não se extrairá o máximo dos dados, sem pessoas capacitadas para extrair significado e percepções sobre os dados estruturados ou não, não servirá de nada qualquer arcabouço de dados.

Atualmente os recursos ligados a analytics estão cada vez mais raros e as nomenclaturas dos cargos/função são os mais variados e chiques por assim dizer, cientistas de dados, analistas de informações gerenciais, business inteligence entre outros.

Novamente, em nossa pesquisa, a experiência do grupo pesquisado foi de que a falta de recursos preparados para a área de analytics tem forte impacto no desempenho da área, além disso, um bom recurso demora entre 3 e 5 anos para ganhar experiência e se tornar um bom recurso, mas ao mesmo tempo a permanência deles na mesma empresa é de até 5 anos o que nos induz acreditar que, quando o recurso ganha senioridade acaba saindo ou sendo convidado para outra organização e deixa a posição atual, famoso “rouba monte” .

Muitos recursos recém-saídos da universidade têm capacidade técnica analítica adequada, mas isso por si só não resolve, sem conhecimento do negócio e dos processos todo este conhecimento técnico não será muito útil. Claramente uma estrutura de aceleração de experiência e coaching de negócio desenhado e conduzido por alguém experiente é fundamental.

Conclusões

Dado o nível de imprescindibilidade, ter um pacote básico com informações gerenciais estruturados toda operação de crédito e cobrança deve ter e presumo que o público que está lendo este capítulo já o possui.

Dentro do processo de crédito e cobrança devemos ter mapeados todos os pontos de controle necessários e informações sobre eles e quando possível com a flexibilidade necessária para que detalhamentos nas análises sejam possíveis.

Invariavelmente estes relatórios estruturados por mais flexibilidade que possuam não serão suficientes para responder as questões em todas as situações apresentadas no seu dia a dia e, portanto, demandas eventuais Ad Hoc ocorrerão e neste sentido um banco de dados estruturado será sempre a solução, desde que desenvolvido dentro de altos padrões de qualidade recomendados.

Recursos adequados, tanto em infraestrutura de software(s) e humano (s) suficientemente bons para desenvolver os estudos analíticos. Conhecimento profundo dos detalhes dos processos envolvidos, o encadeamento lógico e causas e efeitos é matéria prima para estruturar as hipóteses e estudos.

Por fim , o uso da ciência dos dados é a arte de criar um ambiente de aprendizado contínuo, objetivo, disciplinado e criativo.

Sucesso a todos.